13 Wed

TIL

[AI 스쿨 1기] 6주차 DAY 3

선형 분류(Linear Classification)

분류 목표 : 입력벡터 x를 K개의 가능한 클래스 중 하나의 클래스로 할당

판별함수 (Discriminant model)

선형함수에 관한 판별함수에 대해 생각하자.

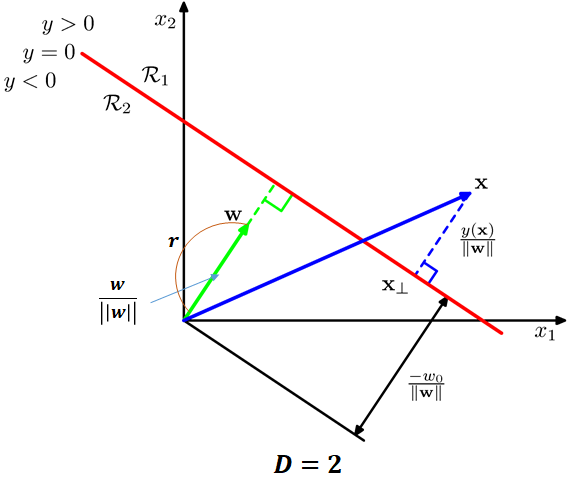

결정 경계(decision boundary)

y(x)=0을 만족하는 x의 집합 (x가 D차원의 입력벡터일 때, D-1차원의 hyperplane)

원점에서 결정 경계면까지의 거리

분류를 위한 최소제곱법 (Least squares for classification)

사실 분류를 위해 최소제곱법 쓰는건 별로 좋지 x❗

분류를 위한 최소제곱법의 문제점✨

outlier에 민감

목표값의 확률분포에 대한 잘못된 가정에 기초❗

퍼셉트론 알고리즘 (The perceptron algorithm)

⭐ 최소제곱법과 퍼셉트론 모두 output 출력하지만, 확률을 계산하진 않음❗

확률적 생성 모델 (Probabilistic Generative Models)

이전 판별함수에서는 에러함수를 최소화하는 최적의 파라미터를 찾는 것이 목적이지만, 확률적 모델은 데이터 분포를 모델링하면서 분류 문제를 결과적으로 풀게됨❗

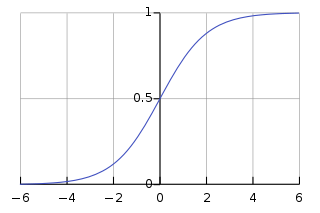

2-class를 가정하고, x가 클래스 1(C1)에 속할 확률

⭐ 2-class : logistic sigmoid function를 이용, k-class : softmax function를 이용❗

데이터가 이산일 때 (Discrete features)

[Statistics 110]

Present Part [3 / 34]

3강- Birthday Problem과 확률의 특성 (Birthday Problem, Properties of Probability)

생일 문제 : 생일이 같은 두 명의 사람을 찾기

가정

2월 29일은 제외한다

365일이 모두 동일한 확률을 가진다

실제로는 그렇지 않다. 예를 들어 9월에 출생이 많다.

독립 : 한 사람의 생일이 다른 사람의 생일에 영향을 미치지 않는다.

최소한 몇명의 사람이 있어야 50%의 확률을 만족할까?

365개의 상자에 공을 최소한 하나씩 집어넣는 경우와 동일

사람이 366명일 경우는 확률이 1이다.

이를 비둘기집 원리라고 한다

대부분의 사람들은 직관적으로 150~180명을 이야기하며 보통 100을 넘는다.

실제로는 23명이 있을 때 50.7%의 확률을 가진다

모두의 생일이 같지 않을 확률

이를 1에서 빼면 적어도 두 명이 생일이 같을 확률을 구하는 것과 같다

P(no match) = 365k365⋅364⋅ ⋯ ⋅(365−k+1) : 365개의 날짜 중 1명이 한 날짜를 차지하면 다른 1명은 남은 364개의 날짜 중 한 날짜를 차지하는 방법

P(match)

50.7% if k = 23

97.0% if k = 50

99.999% if k = 100

k에 대한 직관

(2k)=2k(k−1)

(223)=223⋅22=253

23은 작은 수지만, 23명이 만들 수 있는 쌍의 수는 253개이며 충분히 적어도 한쌍이 생일이 같은지 비교할 수로는 작은 수는 아니다

생일이 같거나 하루 차이 날 확률

about 50% if k = 14

확률 정리

기본 정리

P(∅) = 0, P(S) = 1 and it also means 0≤P(A)≤1

P(∪n=1∞)=∑n=1∞P(An) if An is disjoint with Am(m=n)

속성

P(Ac)=1−P(A)

Proof

1=P(S)=P(A⋃Ac)=P(A)+P(Ac) sinceA⋂Ac=∅

If A⊆B, then P(A)≤P(B)

Proof

B=A⋃(B⋂Ac), disjoint

P(B)=P(A)⋃P(B⋂Ac)

P(A⋃B)=P(A)+P(B)−P(A⋂B)

Proof

P(A⋃B)=P(A⋃(B⋂Ac))=P(A)+P(B⋂Ac)?=P(A)+P(B)−P(A⋂B)

P(B)=P(A⋂B)+P(Ac⋂B) => True

since, P(A⋂B),P(Ac⋂B)are disjoint, union is B

포함배제의 원리, inclusion-exclusion

P(A1⋃A2⋃⋯⋃An)=∑i=1nP(Ai)−∑i<jP(Ai⋂Aj)+∑i<j<kP(Ai⋂Aj⋂Ak)−⋯+(−1)n+1P(Ai⋂⋯⋂An)

몽모르트 문제 : 드 몽모르트가 만든 문제

도박에서 처음 나온 문제

1부터 n까지 적혀있고 각 수마다 한 장만 존재하는 카드 뭉치가 존재

카드를 셔플 후, 카드 뭉치에 있는 카드의 순서와 카드의 값이 일치하는 경우 승리

포함배제의 원리를 이용하여 푸는 것이 가장 쉽다

P(Aj)=n1, j카드가 j-th에 있을 확률, 이 때 j에 대한 식이 아니다

P(A1⋂A2)=n!(n−2)!=n(n−1)1, n개의 카드 중 1과 2가 각각 첫번째와 두번째에 있어야 함

P(A1⋂⋯⋂AK)=n!(n−k)!

P(A1⋃⋯⋃AK)=n⋅n1−2!n(n−1)n(n−1)1+3!n(n−1)(n−2)(n(n−1)(n−2)1−⋯=1−2!1+⋯+(−1)nn!1=1−e1

테일러 급수와 비슷한 모양

Last updated